ChatGPT, el chamullento

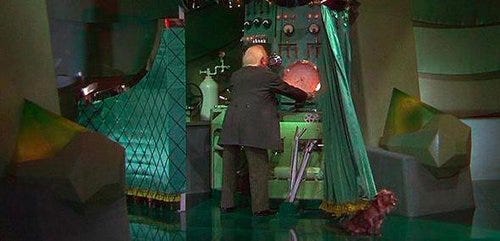

No presten atención al hombrecito tras la cortina

Mucha gente se asombra de las habilidades que muestra ChatGPT, y tiende a pensar que realmente hay “inteligencia detrás”. Pero hay que entender que los LLM son modelos que permiten generar texto a partir de estas enormes bases de texto previo.

En cierta forma podemos ser engañados (se ha afirmado que ChatGPT supera el Test de Turing), pero cuando entend…